Bonjour, merci pour ce tuto.

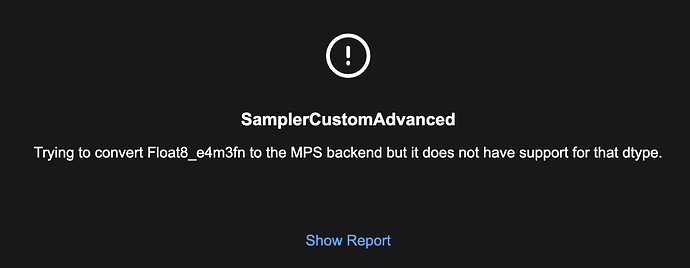

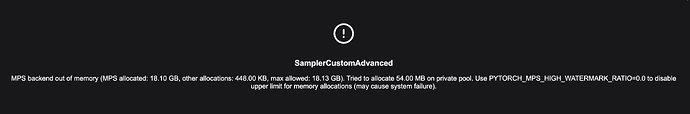

Malheureusement j’ai cette erreur. Quelqu’un saurait d’ou ça vient ?

Merci

le report :

# ComfyUI Error Report

## Error Details

- **Node Type:** SamplerCustomAdvanced

- **Exception Type:** TypeError

- **Exception Message:** Trying to convert Float8_e4m3fn to the MPS backend but it does not have support for that dtype.

## Stack Trace

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 317, in execute

output_data, output_ui, has_subgraph = get_output_data(obj, input_data_all, execution_block_cb=execution_block_cb, pre_execute_cb=pre_execute_cb)

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 192, in get_output_data

return_values = _map_node_over_list(obj, input_data_all, obj.FUNCTION, allow_interrupt=True, execution_block_cb=execution_block_cb, pre_execute_cb=pre_execute_cb)

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 169, in _map_node_over_list

process_inputs(input_dict, i)

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 158, in process_inputs

results.append(getattr(obj, func)(**inputs))

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy_extras/nodes_custom_sampler.py », line 612, in sample

samples = guider.sample(noise.generate_noise(latent), latent_image, sampler, sigmas, denoise_mask=noise_mask, callback=callback, disable_pbar=disable_pbar, seed=noise.seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 716, in sample

output = self.inner_sample(noise, latent_image, device, sampler, sigmas, denoise_mask, callback, disable_pbar, seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 695, in inner_sample

samples = sampler.sample(self, sigmas, extra_args, callback, noise, latent_image, denoise_mask, disable_pbar)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 600, in sample

samples = self.sampler_function(model_k, noise, sigmas, extra_args=extra_args, callback=k_callback, disable=disable_pbar, **self.extra_options)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/utils/_contextlib.py », line 115, in decorate_context

return func(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/k_diffusion/sampling.py », line 144, in sample_euler

denoised = model(x, sigma_hat * s_in, **extra_args)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 299, in call

out = self.inner_model(x, sigma, model_options=model_options, seed=seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 682, in call

return self.predict_noise(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 685, in predict_noise

return sampling_function(self.inner_model, x, timestep, self.conds.get(« negative », None), self.conds.get(« positive », None), self.cfg, model_options=model_options, seed=seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 279, in sampling_function

out = calc_cond_batch(model, conds, x, timestep, model_options)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 228, in calc_cond_batch

output = model.apply_model(input_x, timestep_, **c).chunk(batch_chunks)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/model_base.py », line 142, in apply_model

model_output = self.diffusion_model(xc, t, context=context, control=control, transformer_options=transformer_options, **extra_conds).float()

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1532, in _wrapped_call_impl

return self._call_impl(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1541, in _call_impl

return forward_call(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ldm/flux/model.py », line 159, in forward

out = self.forward_orig(img, img_ids, context, txt_ids, timestep, y, guidance, control)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ldm/flux/model.py », line 104, in forward_orig

img = self.img_in(img)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1532, in _wrapped_call_impl

return self._call_impl(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1541, in _call_impl

return forward_call(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 76, in forward

return self.forward_comfy_cast_weights(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 71, in forward_comfy_cast_weights

weight, bias = cast_bias_weight(self, input)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 50, in cast_bias_weight

bias = cast_to(s.bias, bias_dtype, device, non_blocking=non_blocking, copy=has_function)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 28, in cast_to

return weight.to(dtype=dtype, copy=copy)

## System Information

- **ComfyUI Version:** v0.2.0-1-gd043997

- **Arguments:** main.py

- **OS:** posix

- **Python Version:** 3.10.14 | packaged by conda-forge | (main, Mar 20 2024, 12:51:49) [Clang 16.0.6 ]

- **Embedded Python:** false

- **PyTorch Version:** 2.3.1

## Devices

- **Name:** mps

- **Type:** mps

- **VRAM Total:** 17179869184

- **VRAM Free:** 3021488128

- **Torch VRAM Total:** 17179869184

- **Torch VRAM Free:** 3021488128

## Logs

2024-09-02 20:40:10,487 - root - INFO - Total VRAM 16384 MB, total RAM 16384 MB

2024-09-02 20:40:10,487 - root - INFO - pytorch version: 2.3.1

2024-09-02 20:40:10,487 - root - INFO - Set vram state to: SHARED

2024-09-02 20:40:10,487 - root - INFO - Device: mps

2024-09-02 20:40:11,282 - root - INFO - Using sub quadratic optimization for cross attention, if you have memory or speed issues try using: --use-split-cross-attention

2024-09-02 20:40:12,050 - root - INFO - [Prompt Server] web root: /Users/matthieu/pinokio/api/comfy.git/app/web

2024-09-02 20:40:12,377 - root - INFO -

Import times for custom nodes:

2024-09-02 20:40:12,379 - root - INFO - 0.0 seconds: /Users/matthieu/pinokio/api/comfy.git/app/custom_nodes/websocket_image_save.py

2024-09-02 20:40:12,379 - root - INFO - 0.1 seconds: /Users/matthieu/pinokio/api/comfy.git/app/custom_nodes/ComfyUI-Manager

2024-09-02 20:40:12,379 - root - INFO -

2024-09-02 20:40:12,385 - root - INFO - Starting server

2024-09-02 20:40:12,385 - root - INFO - To see the GUI go to: http://127.0.0.1:8188

2024-09-02 20:40:36,866 - root - INFO - got prompt

2024-09-02 20:40:36,904 - root - INFO - Using split attention in VAE

2024-09-02 20:40:36,906 - root - INFO - Using split attention in VAE

2024-09-02 20:40:37,266 - root - INFO - model weight dtype torch.float8_e4m3fn, manual cast: torch.bfloat16

2024-09-02 20:40:37,266 - root - INFO - model_type FLOW

2024-09-02 20:41:15,842 - root - INFO - Requested to load FluxClipModel_

2024-09-02 20:41:15,847 - root - INFO - Loading 1 new model

2024-09-02 20:41:15,854 - root - INFO - loaded completely 0.0 4777.53759765625 True

2024-09-02 20:41:25,766 - root - WARNING - clip missing: [‹ text_projection.weight ›]

2024-09-02 20:41:33,256 - root - INFO - Requested to load Flux

2024-09-02 20:41:33,257 - root - INFO - Loading 1 new model

2024-09-02 20:42:33,377 - root - INFO - loaded completely 0.0 11340.293029785156 True

2024-09-02 20:42:34,529 - root - ERROR - !!! Exception during processing !!! Trying to convert Float8_e4m3fn to the MPS backend but it does not have support for that dtype.

2024-09-02 20:42:34,573 - root - ERROR - Traceback (most recent call last):

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 317, in execute

output_data, output_ui, has_subgraph = get_output_data(obj, input_data_all, execution_block_cb=execution_block_cb, pre_execute_cb=pre_execute_cb)

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 192, in get_output_data

return_values = _map_node_over_list(obj, input_data_all, obj.FUNCTION, allow_interrupt=True, execution_block_cb=execution_block_cb, pre_execute_cb=pre_execute_cb)

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 169, in _map_node_over_list

process_inputs(input_dict, i)

File « /Users/matthieu/pinokio/api/comfy.git/app/execution.py », line 158, in process_inputs

results.append(getattr(obj, func)(**inputs))

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy_extras/nodes_custom_sampler.py », line 612, in sample

samples = guider.sample(noise.generate_noise(latent), latent_image, sampler, sigmas, denoise_mask=noise_mask, callback=callback, disable_pbar=disable_pbar, seed=noise.seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 716, in sample

output = self.inner_sample(noise, latent_image, device, sampler, sigmas, denoise_mask, callback, disable_pbar, seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 695, in inner_sample

samples = sampler.sample(self, sigmas, extra_args, callback, noise, latent_image, denoise_mask, disable_pbar)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 600, in sample

samples = self.sampler_function(model_k, noise, sigmas, extra_args=extra_args, callback=k_callback, disable=disable_pbar, **self.extra_options)

File "/Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/utils/contextlib.py", line 115, in decorate_context

return func(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/k_diffusion/sampling.py », line 144, in sample_euler

denoised = model(x, sigma_hat * s_in, **extra_args)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 299, in call

out = self.inner_model(x, sigma, model_options=model_options, seed=seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 682, in call

return self.predict_noise(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 685, in predict_noise

return sampling_function(self.inner_model, x, timestep, self.conds.get(« negative », None), self.conds.get(« positive », None), self.cfg, model_options=model_options, seed=seed)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 279, in sampling_function

out = calc_cond_batch(model, conds, x, timestep, model_options)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/samplers.py », line 228, in calc_cond_batch

output = model.apply_model(input_x, timestep, **c).chunk(batch_chunks)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/model_base.py », line 142, in apply_model

model_output = self.diffusion_model(xc, t, context=context, control=control, transformer_options=transformer_options, **extra_conds).float()

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1532, in _wrapped_call_impl

return self._call_impl(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1541, in _call_impl

return forward_call(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ldm/flux/model.py », line 159, in forward

out = self.forward_orig(img, img_ids, context, txt_ids, timestep, y, guidance, control)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ldm/flux/model.py », line 104, in forward_orig

img = self.img_in(img)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1532, in _wrapped_call_impl

return self._call_impl(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/env/lib/python3.10/site-packages/torch/nn/modules/module.py », line 1541, in _call_impl

return forward_call(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 76, in forward

return self.forward_comfy_cast_weights(*args, **kwargs)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 71, in forward_comfy_cast_weights

weight, bias = cast_bias_weight(self, input)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 50, in cast_bias_weight

bias = cast_to(s.bias, bias_dtype, device, non_blocking=non_blocking, copy=has_function)

File « /Users/matthieu/pinokio/api/comfy.git/app/comfy/ops.py », line 28, in cast_to

return weight.to(dtype=dtype, copy=copy)

TypeError: Trying to convert Float8_e4m3fn to the MPS backend but it does not have support for that dtype.

2024-09-02 20:42:34,643 - root - INFO - Prompt executed in 117.78 seconds

## Attached Workflow

Please make sure that workflow does not contain any sensitive information such as API keys or passwords.

{« last_node_id »:51,« last_link_id »:89,« nodes »:[{« id »:11,« type »:« DualCLIPLoader »,« pos »:{« 0 »:131,« 1 »:238,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:106},« flags »:{},« order »:0,« mode »:0,« inputs »:,« outputs »:[{« name »:« CLIP »,« type »:« CLIP »,« links »:[10],« slot_index »:0,« shape »:3}],« properties »:{« Node name for S&R »:« DualCLIPLoader »},« widgets_values »:[« t5xxl_fp8_e4m3fn.safetensors »,« clip_l.safetensors »,« flux »]},{« id »:10,« type »:« VAELoader »,« pos »:{« 0 »:71,« 1 »:509,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:58},« flags »:{},« order »:1,« mode »:0,« inputs »:,« outputs »:[{« name »:« VAE »,« type »:« VAE »,« links »:[12],« slot_index »:0,« shape »:3}],« properties »:{« Node name for S&R »:« VAELoader »},« widgets_values »:[« ae.sft »]},{« id »:16,« type »:« KSamplerSelect »,« pos »:{« 0 »:1370,« 1 »:-160,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:58},« flags »:{},« order »:2,« mode »:0,« inputs »:,« outputs »:[{« name »:« SAMPLER »,« type »:« SAMPLER »,« links »:[19],« shape »:3}],« properties »:{« Node name for S&R »:« KSamplerSelect »},« widgets_values »:[« euler »]},{« id »:9,« type »:« SaveImage »,« pos »:{« 0 »:3290,« 1 »:260,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:686.9293823242188,« 1 »:1089.4158935546875},« flags »:{},« order »:12,« mode »:0,« inputs »:[{« name »:« images »,« type »:« IMAGE »,« link »:88}],« outputs »:,« properties »:{},« widgets_values »:[« flux/ComfyUI »]},{« id »:13,« type »:« SamplerCustomAdvanced »,« pos »:{« 0 »:2250,« 1 »:400,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:355.20001220703125,« 1 »:106},« flags »:{},« order »:10,« mode »:0,« inputs »:[{« name »:« noise »,« type »:« NOISE »,« link »:86,« slot_index »:0},{« name »:« guider »,« type »:« GUIDER »,« link »:30,« slot_index »:1},{« name »:« sampler »,« type »:« SAMPLER »,« link »:19,« slot_index »:2},{« name »:« sigmas »,« type »:« SIGMAS »,« link »:60,« slot_index »:3},{« name »:« latent_image »,« type »:« LATENT »,« link »:89,« slot_index »:4}],« outputs »:[{« name »:« output »,« type »:« LATENT »,« links »:[24],« slot_index »:0,« shape »:3},{« name »:« denoised_output »,« type »:« LATENT »,« links »:null,« shape »:3}],« properties »:{« Node name for S&R »:« SamplerCustomAdvanced »}},{« id »:8,« type »:« VAEDecode »,« pos »:{« 0 »:2700,« 1 »:-20,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:210,« 1 »:46},« flags »:{},« order »:11,« mode »:0,« inputs »:[{« name »:« samples »,« type »:« LATENT »,« link »:24},{« name »:« vae »,« type »:« VAE »,« link »:12}],« outputs »:[{« name »:« IMAGE »,« type »:« IMAGE »,« links »:[88],« slot_index »:0}],« properties »:{« Node name for S&R »:« VAEDecode »}},{« id »:38,« type »:« SplitSigmas »,« pos »:{« 0 »:1650,« 1 »:590,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:78},« flags »:{},« order »:9,« mode »:0,« inputs »:[{« name »:« sigmas »,« type »:« SIGMAS »,« link »:59}],« outputs »:[{« name »:« high_sigmas »,« type »:« SIGMAS »,« links »:,« slot_index »:0,« shape »:3},{« name »:« low_sigmas »,« type »:« SIGMAS »,« links »:[60],« slot_index »:1,« shape »:3}],« properties »:{« Node name for S&R »:« SplitSigmas »},« widgets_values »:[0]},{« id »:17,« type »:« BasicScheduler »,« pos »:{« 0 »:1260,« 1 »:690,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:106},« flags »:{},« order »:7,« mode »:0,« inputs »:[{« name »:« model »,« type »:« MODEL »,« link »:38,« slot_index »:0}],« outputs »:[{« name »:« SIGMAS »,« type »:« SIGMAS »,« links »:[59],« slot_index »:0,« shape »:3}],« properties »:{« Node name for S&R »:« BasicScheduler »},« widgets_values »:[« normal »,4,1]},{« id »:22,« type »:« BasicGuider »,« pos »:{« 0 »:1690,« 1 »:300,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:241.79998779296875,« 1 »:46},« flags »:{},« order »:8,« mode »:0,« inputs »:[{« name »:« model »,« type »:« MODEL »,« link »:39,« slot_index »:0},{« name »:« conditioning »,« type »:« CONDITIONING »,« link »:40,« slot_index »:1}],« outputs »:[{« name »:« GUIDER »,« type »:« GUIDER »,« links »:[30],« slot_index »:0,« shape »:3}],« properties »:{« Node name for S&R »:« BasicGuider »}},{« id »:51,« type »:« EmptyLatentImage »,« pos »:{« 0 »:199,« 1 »:-195,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:106},« flags »:{},« order »:3,« mode »:0,« inputs »:,« outputs »:[{« name »:« LATENT »,« type »:« LATENT »,« links »:[89],« slot_index »:0,« shape »:3}],« properties »:{« Node name for S&R »:« EmptyLatentImage »},« widgets_values »:[1024,576,1]},{« id »:50,« type »:« RandomNoise »,« pos »:{« 0 »:1630,« 1 »:1010,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:82},« flags »:{},« order »:4,« mode »:0,« inputs »:,« outputs »:[{« name »:« NOISE »,« type »:« NOISE »,« links »:[86],« shape »:3}],« properties »:{« Node name for S&R »:« RandomNoise »},« widgets_values »:[688955760961476,« randomize »]},{« id »:6,« type »:« CLIPTextEncode »,« pos »:{« 0 »:672,« 1 »:573,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:422.84503173828125,« 1 »:164.31304931640625},« flags »:{},« order »:6,« mode »:0,« inputs »:[{« name »:« clip »,« type »:« CLIP »,« link »:10}],« outputs »:[{« name »:« CONDITIONING »,« type »:« CONDITIONING »,« links »:[40],« slot_index »:0}],« properties »:{« Node name for S&R »:« CLIPTextEncode »},« widgets_values »:[« a portrait of a duc who has a sign around its nec which says "Flux under 12GB VRAM" in the style of vincent van gogh, heavy brushwork, impasto, painted with a palate knife »]},{« id »:12,« type »:« UNETLoader »,« pos »:{« 0 »:151,« 1 »:14,« 2 »:0,« 3 »:0,« 4 »:0,« 5 »:0,« 6 »:0,« 7 »:0,« 8 »:0,« 9 »:0},« size »:{« 0 »:315,« 1 »:82},« flags »:{},« order »:5,« mode »:0,« inputs »:,« outputs »:[{« name »:« MODEL »,« type »:« MODEL »,« links »:[38,39],« slot_index »:0,« shape »:3}],« properties »:{« Node name for S&R »:« UNETLoader »},« widgets_values »:[« flux1-schnell.sft »,« fp8_e4m3fn »]}],« links »:[[10,11,0,6,0,« CLIP »],[12,10,0,8,1,« VAE »],[19,16,0,13,2,« SAMPLER »],[24,13,0,8,0,« LATENT »],[30,22,0,13,1,« GUIDER »],[38,12,0,17,0,« MODEL »],[39,12,0,22,0,« MODEL »],[40,6,0,22,1,« CONDITIONING »],[59,17,0,38,0,« SIGMAS »],[60,38,1,13,3,« SIGMAS »],[86,50,0,13,0,« NOISE »],[88,8,0,9,0,« IMAGE »],[89,51,0,13,4,« LATENT »]],« groups »:,« config »:{},« extra »:{« ds »:{« scale »:0.42409761837248516,« offset »:[-702.8888034227646,707.6230569550871]}},« version »:0.4}

## Additional Context

(Please add any additional context or steps to reproduce the error here)