Découvrez comment l’intelligence artificielle révolutionne la création de vidéos. Partageons nos expériences, astuces et visions de l’avenir.

Salut Arnaud,

Tu peux nous expliquer comment tu as créé ce clip vidéo :

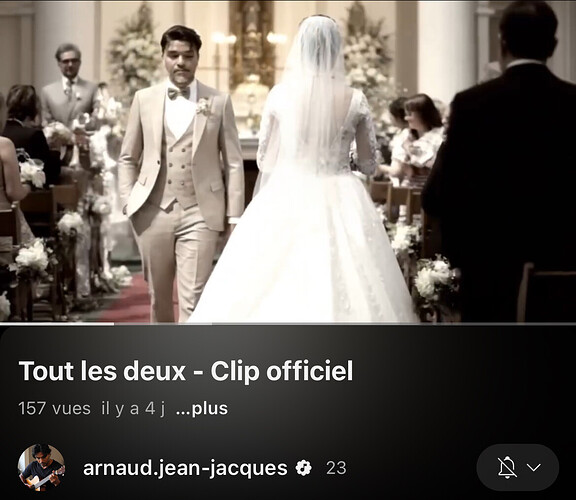

Tu m’as dit sur YouTube qu’il était full IA. Ça m’a surpris.

Raconte ton workflow

Bonsoir Janviet,

Merci pour l’invitation à participer au forum. Je suis à la base musicien et compositeur, mais je ne possède qu’une guitare. J’ai donc activé le micro et chanté ma chanson en m’accompagnant avec ma guitare sur Suno. Ensuite, j’ai ajouté les paroles phonétiquement, en précisant de les orchestrer tout en restant fidèle à ma voix et en la masterisant. Cela a donné la chanson que tu entends dans le clip.

Par la suite, ayant une formation en audiovisuel, j’ai compris qu’il fallait guider l’IA pour la réalisation. J’avais déjà le scénario du clip en tête. J’ai donc demandé à Copilot, l’IA que j’utilisais à l’époque, de me fournir les noms des plans, les angles de vue et les mouvements de caméra, afin que le rendu ait un aspect professionnel.

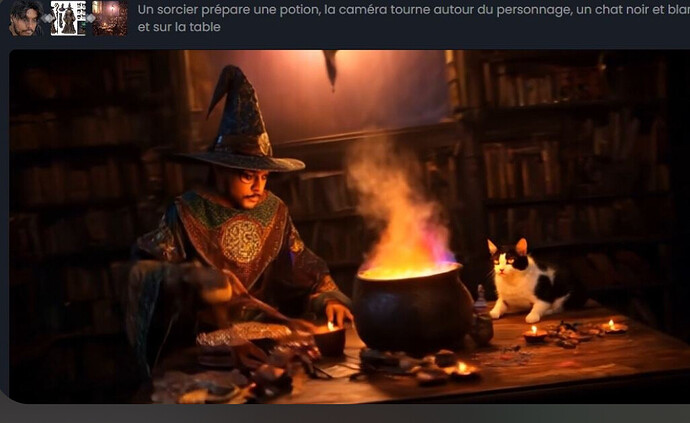

Par la suite, j’ai voulu créer mon propre personnage de référence en m’appuyant sur la technique des modèles sheets utilisée dans le cinéma d’animation. J’ai d’abord fait des essais sur Kling pour vérifier s’il était possible de rassembler toutes les images nécessaires sur une seule image afin de les inclure dans le prompt. J’ai testé cela avec une scène de sorcier, où j’ai utilisé ma tête sur la première image de référence. À l’époque, Kling était limité à trois images, alors j’ai placé le reste des éléments sur la deuxième et décoré sur la troisième image : la pièce où devait se dérouler la scène, le chaudron dans lequel je préparais la potion, et le chat qui devait se tenir sur la table. J’en ai conclu que cette méthode était idéale pour entraîner l’IA.

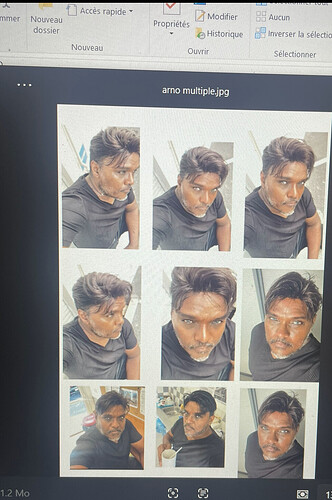

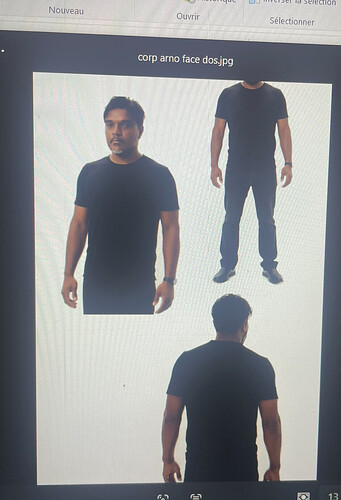

Du coup, j’ai créé mon propre modèle sheet. J’ai placé ma tête dans toutes les positions sur la première image, mon corps sur la deuxième, et je l’ai dans les characters de vidu. Détaille important met le nom du personnage sur l’image importer comme cela l’ia la garde en mémoire quand tu fait les autre promt, mais j’ ai fait pour mon nouveau clip, pour « ti mamzel, je l’ai fait à la old school, deux ou trois photos d’angle différents.

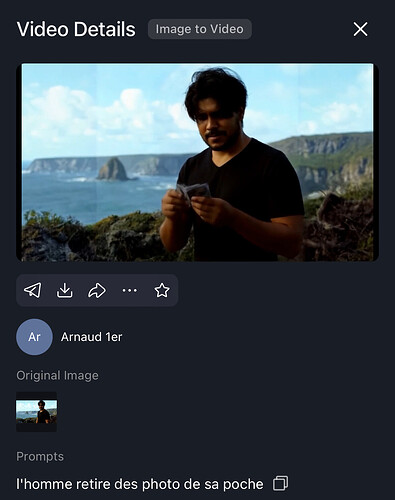

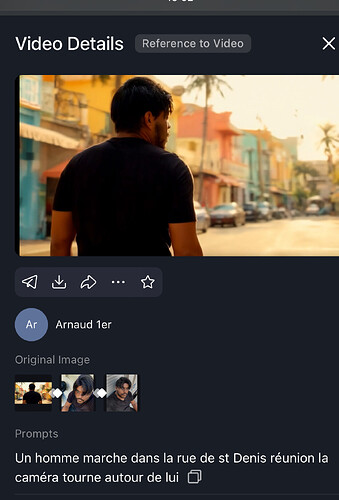

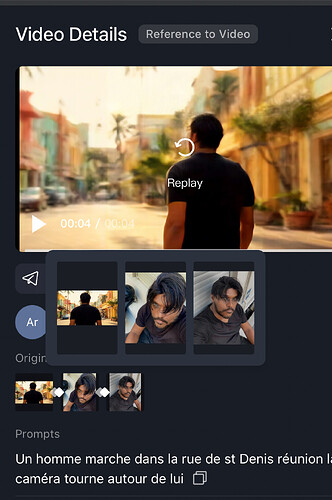

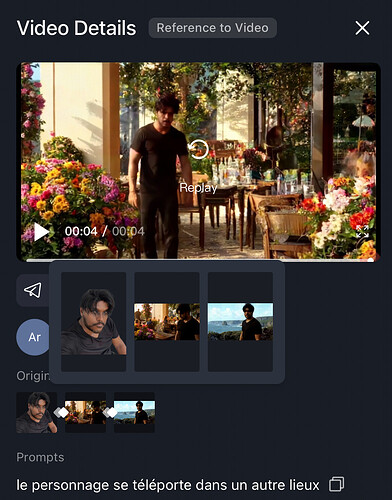

J’ai utilisé uniquement des générations d’images de 4 secondes. Pour prolonger la scène, il suffit de faire une capture d’écran de la dernière image et de demander de continuer la scène. L’avantage de Vidu ça ne coûte que 5 à 16 credit et ça génère la vidéo en 30 secondes. Image to vidéo pour les scènes avec un décor fixe, et référence to vidéo si on fait appel à un changement d’angle de caméra, ou un mouvement de caméra comme cité plus haut.

« Ti Mamzel » est le premier clip que j’ai réalisé avec l’IA. Au départ, je ne connaissais pas la technique du modèle sheet.

J’utilisais plusieurs image de références avec des photos de cadrage différent

Pour les lips j’aurai pu utiliser weidghts ai, mais j ai choisis l’option de chanter reelement, pour mettre un peu de l’humain dans la vidéo ![]()

Il y a deux options : image to vidéo et référence vidéo. J’utilise la référence vidéo lorsque je veux modifier l’angle de la caméra, le mouvement de la caméra ou le cadrage. Quant à image to vidéo, je m’en sers pour créer des animations dans un plan fixe, comme une entrée en scène, une marche… tout en conservant le même cadrage.

Et enfin, après avoir vu ta vidéo sur la mise à jour GPT-4O, cela m’a donné l’idée de préparer et créer mon premier court métrage en cartoon 3D. J’ai déjà finalisé le scénario et préparé toutes les images en amont grâce à GPT-4O.

J’utiliserai Weights pour la voix. Il y a des faux raccords sur le plan d’ensemble que je corrigerai au moment venu.

Excellent Arnaud, tout ce que tu as partagé. Donc tu utilises Vidu pour toutes tes vidéos IA et pas Kling AI ?

Je vais prendre le temps de lire en détails tout en workflow, c’est très précis en tout cas.

Oui kling revient très chers la génération, ça peut aller jusqu’à 100 crédits, sur vidu c’est 16 ensuite tu agrandis le format avec l’ia, soit sur cap cut ou topaz, ou encore sur première pro.

Et vidu tu peux avoir 7 images de références, et les caractères récurent sont compris alors que kling c’est 1000 crédits par caractère

Bonjour à nouveau !** Je suis en train de préparer une vidéo pour expliquer comment j’ai réalisé mon clip Ti Mamzel. Le tuto est réalisé sur vidu, en full ia et hedra. J ai déjà préparer un short. https://youtube.com/shorts/dycKRW-FVLA?si=kdDazfgKknwZ2Ql-

Pour le scénario, gpt4o m’a été d’un grand secours.

Il m’a permis d’avoir une trame pour le speech

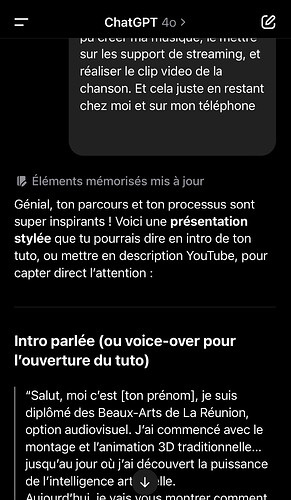

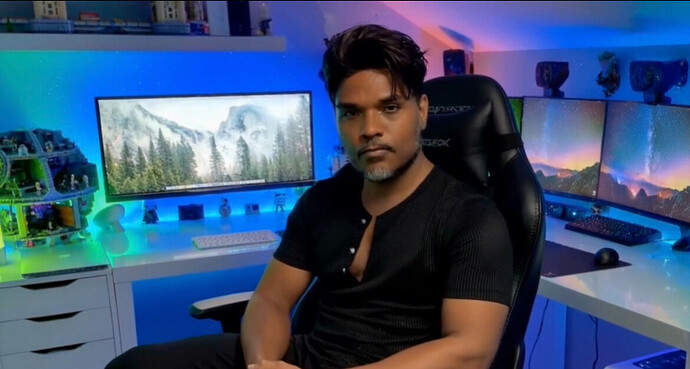

Pour le visuel j ai récupérer un décor de youtubeur sur google, je pouvais pas prendre mon bureau comme il est bordélique ![]()

J’ai demandé à Vidu, qui avait déjà mon personnage en modèle, de le placer sur le siège. Je voulais créer un style multi-caméra pour rendre la scène plus dynamique et masquer les faux raccords, en utilisant trois angles de caméra. Du coup, j’ai aussi demandé à l’IA d’effectuer une rotation autour du personnage.

À un moment de la vidéo, je présente Jeanviet, dont les tutoriels m’ont grandement inspiré pour la réalisation du clip. Sa page YouTube apparaît à l’écran, et j’invite les spectateurs à cliquer sur les liens disponibles dans la description.

Puis, j’entre dans le vif du sujet en présentant quelques extraits de Ti Mamzel et Soleil. Je précise que tout a été réalisé uniquement avec un téléphone, en détaillant les outils utilisés.

J arrive pas à importer les rusch de vidéo dans le forum. Du coup je ne peut présenter la première parti finalisé.

Le problème de hedra c’est que les mains du personnage bouge sans arrêt cela ne fait pas trop naturel, du coup j ai du zoomer sur l image parfois pour qu’il ne soit pas visible

En parallèle, je travaille sur mon clip Somanké, un projet d’animation mettant en scène un personnage endémique de l’île de La Réunion. Je suis à l étape où je génère les images

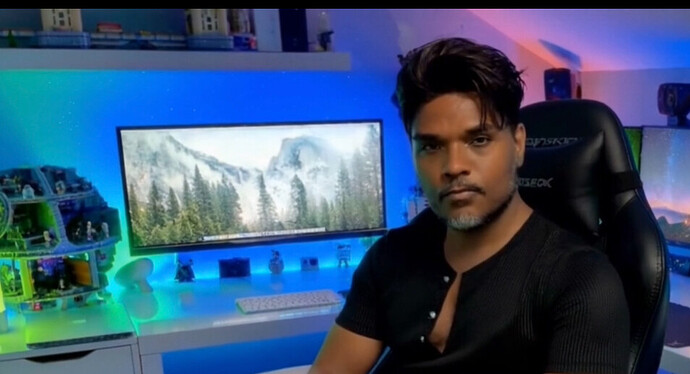

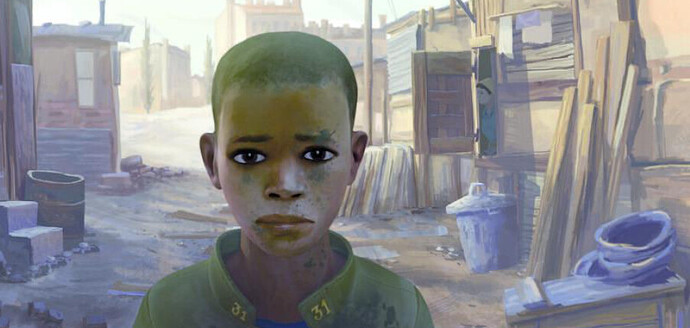

Pour mon clip somanké j ai voulue le faire dans le même style que le dessina d’animation

« Adama »

Voici la bande annonce d’Adama

Pour avoir le même style, j’ai mis deux image de référence dans gpt4 et demander de me fournir le json. Pour avoir les code graphique du style dans mes futures images.

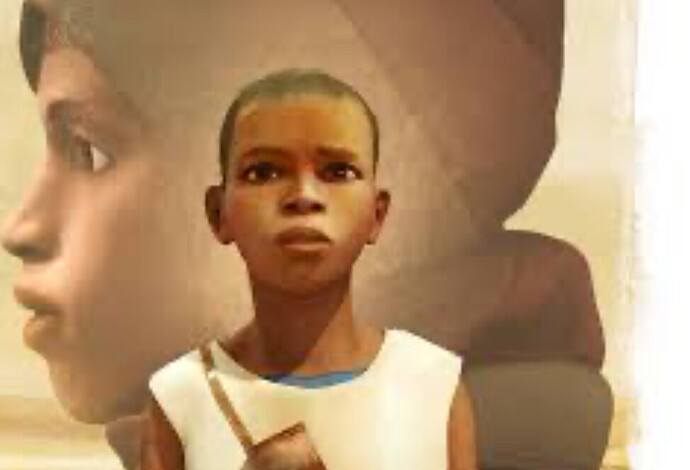

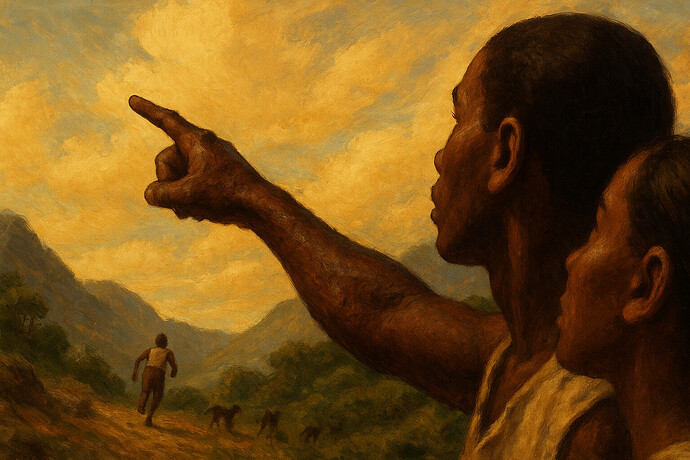

Cela m’a permis de définir le style de mon animation. Voici les premières images : l’histoire se déroule à l’époque des colonies, durant la traite des esclaves.

Dans le json apparaissait le nom de style adama. Et de ce fait gpt4 ne voulais pas générer les images par respect au consigne de droit. Mais en enlevant le nom d’Adama dans le json. Cela a fait sauter l interdiction. Et il a pu gênerais les images.

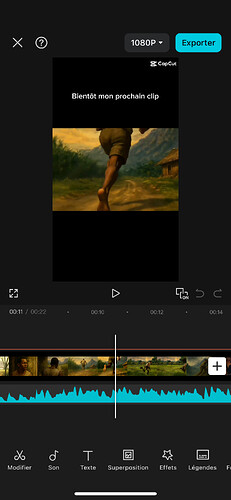

Pour chaque scène, je génère toujours deux ou trois angles différents de la même prise. Comme dans le tutoriel, j’ai fait parler mon personnage sous trois angles distincts, puis, lors du montage, je synchronise les pistes vidéo pour un rendu fluide et dynamique.

Voici en exemple une course de mon personnage pour le clip somanké, où il y a 3 angle de vue différentes de la même scène